ChatGPT, Bard e ErnieBot: perché chiedere all’intelligenza artificiale non è sempre intelligente

Cosa sono e come funzionano i chatbot basati sull'intelligenza artificiale e perché i limiti sono ancora molti

La risposta è dentro l’algoritmo, epperò non sempre è corretta: il 2023 si è aperto nel segno delle IA-Quèlo. Nel 1997, agli albori di internet e pochi mesi prima del lancio di Google, il comico Corrado Guzzanti interpretava il personaggio di Quèlo, profeta-santone che trovava una risposta a qualunque quesito riducendolo a pochi schemi noti e alla propria esperienza personale. Il culto della divinità omonima di cui si faceva portatore, incarnata in un pezzo di legno con dei chiodi e uno smiley, si fondava infatti sulle sue risposte-rivelazioni.

Guzzanti e il personaggio di QuèloCos’è ChatGPT

Ventisei anni dopo, l’applicazione a più veloce crescita di utenti della storia è ChatGPT, un software programmato per sostenere una conversazione scritta e rispondere a qualsiasi tipo di domanda. In due mesi, si sono rivolte a ChatGPT 100 milioni di persone, un milione solo nei primi cinque giorni (30 novembre-5 dicembre).

Un successo che ha spinto la corsa delle big tech sulle intelligenze artificiali conversazionali, anche a colpi di comunicati stampa. ChatGPT è stata rilasciata da OpenAI, azienda dal 2019 finanziata da Microsoft. Che prima ha esteso la partnership (23 gennaio), poi ha annunciato l’integrazione del servizio nel motore di ricerca Bing e nel browser Edge (7 febbraio). Sfidando Alphabet/Google sul suo storico business. Al posto della lista dei link delle pagine web pertinenti, l’utente riceverà come risposta una sintesi elaborata da ChatGPT.

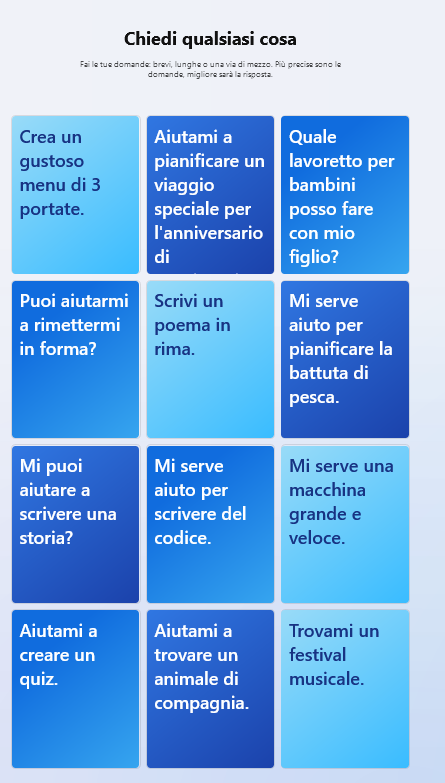

Un’anteprima del servizio, ancora in betatest, è disponibile in Italia con alcune domande standard. Qualche esempio: «Puoi aiutarmi a rimettermi in forma?», «Scrivi un poema in rima», «Crea un gustoso menu di tre portate», «Quale lavoretto per bambini posso fare con mio figlio?».

Fioriscono i chatbot: da ErnieBot a Bard

Nella demo di lancio americana, ha notato CNBC, l’IA integrata in Bing ha compiuto diversi errori. Da Microsoft rispondono che nel periodo di preview il sistema può commettere degli sbagli ma i feedback ricevuti lo aiuteranno a migliorare.

Sempre il 7 febbraio scorso, la cinese Baidu ha ufficializzato il lancio del proprio chatbot ErnieBot a marzo. Mentre il giorno prima la stessa Alphabet/Google aveva presentato il proprio rivale di ChatGPT, Bard, come un aiuto «a spiegare le nuove scoperte del telescopio spaziale James Webb della Nasa a un bambino di 9 anni».

Proprio la risposta dell’IA sul telescopio si è rivelata un boomerang: pubblicizzata nel video di lancio, suggeriva tra le scoperte le prime foto di un Pianeta fuori dal sistema solare, scattate invece dal Very Large Telescope dello European Southern Observatory nel 2004, come specificato dalla stessa Nasa. Un errore costato oltre 100 miliardi di dollari in perdite azionarie.

Anche Meta si è lanciata nel business, ma per ora l’esperimento è durato 48 ore

Anche Meta aveva provato a lanciare il proprio chatbot IA, Galactica, due settimane prima di ChatGPT. Prometteva di essere un’enciclopedia digitale permanente, un’interfaccia affidabile per gli scienziati. È stato chiuso dopo poco più di 48 ore per risposte inventate, più o meno verosimili, e serie difficoltà con le operazioni matematiche basilari come fare uno più uno.

Il 15 febbraio lo studio legale Allen&Overy, che si occupa dei principali affari della City di Londra, ha dichiarato al Financial Times di avere testato a novembre il chatbot Harvey, basato su ChatGPT, di averlo introdotto per aiutare i propri avvocati a redigere i contratti e di non aver ritenuto necessario informare i propri clienti di questa operazione.

Il caso dello studio legale londinese Allen&Overy (che cura affari alla City)

L’assistente IA, riporta il Financial Times, è accompagnato da un disclaimer di esclusione di responsabilità per il suo utilizzo, che deve essere quindi supervisionato. E di avvertenze sulle hallucination (o allucinazioni), ovvero la possibilità di ottenere risposte insensate, verosimili ma false, tendenziose. Perché troppo basate sul set di dati di apprendimento. Ma lo scopo dell’operazione, sostiene lo studio legale, è produrre bozze di documenti da poter modificare o migliorare.

L’introduzione dei chatbot IA nei settori in cui è richiesta elaborazione di documenti in tempi brevi (amministrazione, editoria e comunicazione, giurisprudenza, finanza) è infatti il prossimo passo dell’adozione di questi strumenti. Ma come funzionano?

Leggi anche

Che fine fa il diritto del lavoro se “il tuo capo è un algoritmo”?

Nel saggio “Il tuo capo è un algoritmo”, Antonio Aloisi e Valerio De Stefano tracciano le prospettive del mercato del lavoro

Cosa sono e come funzionano le IA conversazionali come Siri o Alexa

Le IA conversazionali sono chatbot. Ovvero software programmati per sostenere una conversazione scritta o orale. Gli assistenti vocali come Siri (2012) e Alexa (2014) sono stati i primi risultati dei progressi dell’elaborazione del linguaggio naturale (Natural language processing), che dagli anni Novanta si è spostata sul machine learning a base statistica. Ovvero su algoritmi di apprendimento automatico che correlano dati a partire dalle “etichette” ricevute (apprendimento supervisionato). O a partire dagli schemi ricorrenti trovati nei dati stessi (non supervisionato).

A propria volta, il machine learning si è evoluto nel deep learning, l’apprendimento profondo, basato su reti neurali artificiali. Strutture algoritmiche che funzionano per connessioni “plastiche”, capaci di modificarsi durante l’apprendimento, e per livelli (layers) di elaborazione di caratteristiche sempre più raffinati. Il risultato del livello precedente fornisce l’input di quello successivo. Una struttura anche detta “Black box”, scatola nera, perché non è possibile ricostruire tutti i passaggi dell’elaborazione ma solo gli input in entrata e gli output in uscita. Non è quindi possibile capire fino in fondo le ragioni dell’algoritmica decisione.

La rete neuronale Transformer di Google

Sia Siri che Alexa sono basate su reti neurali artificiali che eseguono compiti su richiesta e forniscono informazioni senza conservare le interazioni precedenti. Nel 2017 Google Research ha pubblicato “Attention is all you need”, il paper di presentazione della rete neurale Transformer su cui si basano sia ChatGPT che Bard, in grado di processare contemporaneamente un’intera frase o periodo, riconoscerne le parole più importanti e, a partire da quelle, produrre la propria risposta.

Ogni risposta delle IA conversazionali basate su Transformer, quindi, è in parte formata dalle parole che la rete algoritmica ha trovato associate più spesso alle parole della domanda, in parte da quelle che ritiene più probabili. Le IA non capiscono quello che dicono o scrivono: un po’ ripetono quanto hanno imparato durante l’addestramento (c’è chi le ha definite “pappagalli stocastici”) un po’ fanno un calcolo statistico.

Chat Generative Pre-trained Transformer è stato addestrato per prevedere la parola successiva su un ampio dataset di testi internet: all’interno del deep learning, sono stati previsti momenti in cui esseri umani hanno classificato le diverse risposte fornite dall’IA (Reinforcement learning from human feedback) per ottimizzare il modello.

IA e finanza

Un chatbot come consulente finanziario: è davvero una buona idea?

Dopo il successo di ChatGPT, le società finanziarie guardano con interesse ai chatbot. Ma i dubbi da sbrogliare sono ancora parecchi

I chatbot che assorbono anche pregiudizi e gli esseri umani pagati 1,3 dollari l’ora

Infatti, le IA che imparano dai testi umani ne assorbono anche i pregiudizi: GPT-3, il predecessore di ChatGPT, era molto incline ai commenti violenti, sessisti e razzisti, ricorda il Time. Per creare un filtro automatizzato, secondo il report pubblicato il 18 gennaio dal settimanale statunitense, OpenAI ha quindi inviato decine di migliaia di frammenti di testi violenti e tossici da etichettare a una società di outsourcing in Kenya, a partire dal novembre 2021.

Gli esseri umani etichettatori sono stati pagati da 1,3 a 2 dollari l’ora per esaminare testi con dettagli grafici di abusi sessuali, omicidio, suicidio, tortura. A febbraio 2022 i rapporti tra la società di outsourcing e OpenAI si sono interrotti ma il tema dei costi umani dell’etichettatura per l’IA dei contenuti, specie se violenti e tossici, resta.

Brenda, il chatbot usato nel mercato immobiliare e i costi ambientali dell’intelligenza artificiale

Il Guardian ha riportato la testimonianza dell’addestratore di un altro chatbot, Brenda, utilizzato nel mercato immobiliare. Il suo compito è stato controllare le chat e prendere il controllo del bot nei casi in cui non sapeva rispondere al cliente, in modo da affinare il modello. Ovvero: «Fingere di essere un bot che fingeva di essere una persona». Dopo settimane, «mi è venuto in mente che non stavo addestrando Brenda a pensare come un essere umano. Ma che Brenda stava addestrando me a pensare come un bot. E forse questo è sempre stato il punto».

Per il filosofo Luciano Floridi, AI è acronimo di “Agere sine Intelligere”, azione senza intelligenza. Mentre il tecnologo Massimo Chiriatti parla di IA come “Incoscienza Artificiale”. Entrambi sottolineano come oggi la questione principale non sia più stabilire se l’IA sia intelligente in senso umano, perché non lo è. È invece capire cosa succederà se non riusciremo più a distinguere l’autore di un testo o di una risposta: è un agente artificiale o umano? E chi è, già oggi, responsabile delle azioni senza pensiero delle IA?

Un altro tema è quello della sostenibilità ambientale: l’impronta energetica di una IA passa dall’alimentazione della potenza di calcolo per l’addestramento, dall’esecuzione del modello, dal suo intero ciclo di vita. OpenAI non risponde alle richieste di commento sui propri obiettivi ambientali. È stato stimato che una singola sessione di GPT-3 avrebbe prodotto 223.920 chilogrammi di CO2 o equivalente. Il cervello umano consuma 20 watt, quanto una lampadina. In attesa che migliori, cosa sacrificheremo sull’altare di Quèlo?